"From Deep Learning to Rational Machines/Imagination"의 두 판 사이의 차이

| (같은 사용자의 중간 판 4개는 보이지 않습니다) | |||

| 10번째 줄: | 10번째 줄: | ||

둘째, 사고의 생산성 문제 : 경험주의적 마음은 과거에 한 번도 경험해 본 적 없는 새로운 복합 관념을 어떻게 형성할 수 있는가? 포더는 경험을 통해 획득한 관념의 분해와 자유로운 재합성에 호소하는 흄의 설명이 겉보기에만 훌륭할 뿐, 세부사항이 없는 빈 설명이라고 불평한다. | 둘째, 사고의 생산성 문제 : 경험주의적 마음은 과거에 한 번도 경험해 본 적 없는 새로운 복합 관념을 어떻게 형성할 수 있는가? 포더는 경험을 통해 획득한 관념의 분해와 자유로운 재합성에 호소하는 흄의 설명이 겉보기에만 훌륭할 뿐, 세부사항이 없는 빈 설명이라고 불평한다. | ||

셋째, 사고 간의 인과적 관계와 의도적 관계 구별하기의 문제 : 흄은 연합된 이미지는 경험에서 복사된 것이 아니라 상상력에 의해 종합된 것이며, 그 연합된 이미지의 강도를 통해 신뢰성을 검토한다고 얘기한 바 있는데, 이는 오늘날의 확률적 추론에 대한 휴리스틱 접근의 전신이라 할 수 있다. | 셋째, 사고 간의 인과적 관계와 의도적 관계 구별하기의 문제 : 포더에 따르면, 연합주의는 사고의 내용 사이의 의도적(의미론적) 관계와 사고 자체의 인과적 관계를 구별하지 못한다. ... 흄은 연합된 이미지는 경험에서 복사된 것이 아니라 상상력에 의해 종합된 것이며, 그 연합된 이미지의 강도를 통해 신뢰성을 검토한다고 얘기한 바 있는데, 이는 오늘날의 확률적 추론에 대한 휴리스틱 접근의 전신이라 할 수 있다. | ||

===흄의 상상력 설명에 대한 포더의 비판=== | ===흄의 상상력 설명에 대한 포더의 비판=== | ||

| 28번째 줄: | 28번째 줄: | ||

우리 또는 인공 모델은 어떻게 새로운 (구체적인) 관념을 합성할 수 있는가? 이는 추상화와 반대 방향의 과정으로, "변형된 범주 매니폴드"에서 "완전한 렌더링된 특정 항목"으로 돌아가는 과정, 일반적인 범주 표상에서 특정한 관념으로 돌아가는 과정이다. 이를 위해 버크너는 적대적 생성 신경망에서부터 시작한다. | 우리 또는 인공 모델은 어떻게 새로운 (구체적인) 관념을 합성할 수 있는가? 이는 추상화와 반대 방향의 과정으로, "변형된 범주 매니폴드"에서 "완전한 렌더링된 특정 항목"으로 돌아가는 과정, 일반적인 범주 표상에서 특정한 관념으로 돌아가는 과정이다. 이를 위해 버크너는 적대적 생성 신경망에서부터 시작한다. | ||

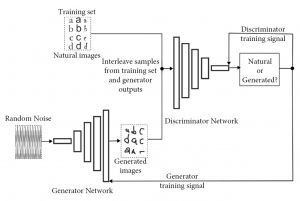

적대적 생성 신경망(GAN : 생성 신경망 + 판별 신경망) : 생성 신경망이 가짜 입력을 만들고, | 적대적 생성 신경망(GAN : 생성 신경망 + 판별 신경망) : 생성 신경망이 가짜 입력을 만들고, 판별 신경망은 그것이 진짜인지 가짜인지 판별함으로써, 생성 신경망 훈련시킨다. 그러면 GAN은 어떤 구조로 구체적인 가짜 입력을 만들어내고, 진짜 같은 가짜를 만들어내는 데 성공할 수 있을까? | ||

[[그림:GAN.png|thumb|적대적 생성 신경망(GAN)의 구조]]생성 신경망은 기본적으로 DCNN과 유사하지만, 첫째, GAN의 입력은 (DCNN의 고차원 정보와 반대로) 저차원의 특징 공간(잠재 공간이라 부름)의 (랜덤) 벡터이며, GAN의 작동 과정은 (DCNN의 합성과 풀링의 반대로) '''전치 합성곱'''과 '''언풀링'''으로 이루어지며, 이를 통해 생성 신경망은 저차원의 잠재 공간 벡터로부터 고해상도의 표본을 생성한다. 물론 처음에는 엉터리 표본을 생성하지만,판별 신경망의 판별 결과에 따른 훈련을 통해, 생성 신경망은 잠재 공간의 의미있는 특징들에 대한 풍부한 정보들을 활용할 수 있는 방식으로 진화하여, 판별 신경망을 속일 수 있는 표본을 생성하게 된다. | [[그림:GAN.png|thumb|적대적 생성 신경망(GAN)의 구조]]생성 신경망은 기본적으로 DCNN과 유사하지만, 첫째, GAN의 입력은 (DCNN의 고차원 정보와 반대로) 저차원의 특징 공간(잠재 공간이라 부름)의 (랜덤) 벡터이며, GAN의 작동 과정은 (DCNN의 합성과 풀링의 반대로) '''전치 합성곱'''과 '''언풀링'''으로 이루어지며, 이를 통해 생성 신경망은 저차원의 잠재 공간 벡터로부터 고해상도의 표본을 생성한다. 물론 처음에는 엉터리 표본을 생성하지만,판별 신경망의 판별 결과에 따른 훈련을 통해, 생성 신경망은 잠재 공간의 의미있는 특징들에 대한 풍부한 정보들을 활용할 수 있는 방식으로 진화하여, 판별 신경망을 속일 수 있는 표본을 생성하게 된다. | ||

| 42번째 줄: | 42번째 줄: | ||

GAN은 포더가 제기한 두 번째 문제, 즉 어떻게 경험주의적 마음이 새로운 관념을 합성할 수 있는지의 문제도 해결할 수 있다. GAN의 생성 신경망에 무작위 잡음 대신 잠재 공간의 특성과 잘 매핑된 벡터를 입력하면 원하는 여러 특징들을 가진 새로운 합성물을 생성할 수 있다. 이를 "내삽"의 방법이라 부른다. 예를 들어 잠재 공간 내에서 "남자", "안경 쓴 남자", "여자"의 벡터 좌표를 이용하면, "안경 쓴 남자"-"남자"+"여자"의 벡터를 생성 신경망에 입력하여 렌더링하면 "안경 쓴 여자"의 그럴듯한 표본을 생성할 수 있다. 이러한 방법은 스타일 벡터를 이용한 새로운 주제의 그림 생성에도 사용되었고, 대성공을 거두었다. | GAN은 포더가 제기한 두 번째 문제, 즉 어떻게 경험주의적 마음이 새로운 관념을 합성할 수 있는지의 문제도 해결할 수 있다. GAN의 생성 신경망에 무작위 잡음 대신 잠재 공간의 특성과 잘 매핑된 벡터를 입력하면 원하는 여러 특징들을 가진 새로운 합성물을 생성할 수 있다. 이를 "내삽"의 방법이라 부른다. 예를 들어 잠재 공간 내에서 "남자", "안경 쓴 남자", "여자"의 벡터 좌표를 이용하면, "안경 쓴 남자"-"남자"+"여자"의 벡터를 생성 신경망에 입력하여 렌더링하면 "안경 쓴 여자"의 그럴듯한 표본을 생성할 수 있다. 이러한 방법은 스타일 벡터를 이용한 새로운 주제의 그림 생성에도 사용되었고, 대성공을 거두었다. | ||

한 가지 쟁점 : 잠재 요인을 모델에서 얼마나 명시적으로 표상해야 하는가? 대안적 접근 방법 중 하나인 변분 오토인코더(VAEs)는 잠재 요인을 명시적으로 분리해냄으로써 그러한 요인들을 혼합하고 조작하기 쉽게 만들어준다. VAE에 추가된 트릭들은 그 추출된 잠재 요인을 인간이 사용하는 것과 더 유사하게 만들어준다. | 한 가지 추가적인 쟁점 : 잠재 요인을 모델에서 얼마나 명시적으로 표상해야 하는가? 대안적 접근 방법 중 하나인 변분 오토인코더(VAEs)는 잠재 요인을 명시적으로 분리해냄으로써 그러한 요인들을 혼합하고 조작하기 쉽게 만들어준다. VAE에 추가된 트릭들은 그 추출된 잠재 요인을 인간이 사용하는 것과 더 유사하게 만들어준다. | ||

위와 같은 발전은 새로운 복합 관념을 생성하는 능력에 대한 포더의 문제제기에 대한 훌륭한 답이 될 수 있다. 위의 생성 신경망들은 경험으로부터 학습하지만, 그것의 재합성을 넘어 완전히 새로운 것을 조합할 수 있다. | 위와 같은 발전은 새로운 복합 관념을 생성하는 능력에 대한 포더의 문제제기에 대한 훌륭한 답이 될 수 있다. 위의 생성 신경망들은 경험으로부터 학습하지만, 그것의 재합성을 넘어 완전히 새로운 것을 조합할 수 있다. 이는 잠재 공간을 이용한 추상화된 특성들의 학습과 그 특성들의 조합, 특성의 전형적 표본 생성 능력에 기반하고, 이는 모두 경험주의 도구 상자의 범위 내에 잘 들어맞는다. | ||

이에 대해 두 가지 반론이 가능하다. 첫째, 인공 신경망이 사용하는 내삽 절차가 과연 순수히 경험주의적인가? 둘째, 인공 신경망이 인간의 능력에는 도달하지 못하고 있지 않은가? 즉 내삽만 할 뿐, 외삽은 못하지 않는가? 이에 대해 버크너의 답은 다음과 같다. 첫째, 현재의 내삽 방법이 고전적인 방법을 사용하는 것은 프로그래머의 편의일 뿐, 영역 일반적인 내삽 방법은 탐구하면 된다. 둘째, 인강 신경망의 성취 충분히 인상적이며, 내삽과 외삽의 구분선은 애매하다. 어쩌면 인간이 외삽을 할 수 있다는 건 인간중심적 착각일 수도. | |||

== 창의적 적대 신경망 == | |||

이제 초점을 예술적 창의성에 제한해보자. 여기서 요구되는 새로움은 자유와 제약의 혼합이다. 즉 단순히 무작위적인 것은 미적으로 흥미롭지 않다. 흥미로운 형태의 새로움은 "이전 경험에 의해 정보를 제공받지만, 그에 비추어 볼 때 이해 가능하거나 가치 있고 생각될 수 있는 것의 한계를 밀어붙이는 것"이다. 예술적 목적을 위해 신경망의 두 가지 방향의 혁신을 생각해볼 수 있다. 첫째는 미적 판별 신경망, 둘째는 미적 생성 신경망. 미적 판별 신경망은 미적 우수성을 인간처럼 평가하도록 훈련시킨 신경망이고(e.g., DCM), 미적 생성 신경망은 형태나 스타일 면에서 새로움을 극대화하여 흥미로운 새로움 탐색에 특화된 신경망이다(e.g., CAN : 훈련 세트의 라벨에서 스타일 표현들을 학습한 후, 적대적 훈련 과정에서 새로운 스타일 표현을 학습하여 명시적으로 그것들과 벗어나는 표본을 생성). | |||

== 경험의 시뮬레이션 == | |||

시뮬레이션된 경험은 새로운 표상을 발견하고, 미래와 반사실적 상황을 생각하여 의사결정과 인과 추론에 도움을 줄 수 있다. 이 영역에서 상상은 에피소드 기억과 접합됨. 단, 알파고 등이 사용한 몬테카를로 트리 탐색은 경험적인 방법은 아니며, 지나치게 포괄적이며 이미 잘 정의된 탐색 공간을 활용한다. 여기서 추구하는 상상 기반 계획은 경험에 의해 안내되고, 더 효율적이고 현실 세계에서 문제 해결을 특징짓는 더 혼란스럽고 덜 정의된 탐색 공간에 적용될 수 있어야 한다. | |||

수면이나 몽상의 역할이 약간 밝혀져 있다. 미로 탐색 훈련을 받는 쥐들에 대한 연구에서, 수면과 휴식 기간 동안 쥐들의 내측 측두엽은 이전 경로 및 새로운 경로에 대응되는 발화 패턴을 보였다. 인간과 동물의 효율적으로 보이는 학습 능력은, 휴식기에 일종의 시뮬레이션된 경험 덕분일 수 있다. | |||

GAN 등 DNN 기반 생성 모델들도 유사한 이점을 얻을 수 있다. 예를 들어 SimGAN은 GAN 방법을 통해 수많은 시뮬레이션 데이터를 생성하고, 이를 통해 판별 신경망의 정확도를 향상시킨다. 물론 과적합의 우려가 있긴 하지만, 이를 피하는 방법도 이미 개발되어 있다. | |||

의사결정에 시물레이션된 경험을 활용하는 데 있어 상상력이 수행하는 역할은 보다 까다롭다. 상상력은 완전한 탐색보다 효율적으로 고려한 미래 작업의 작은 집합을 채워주어야 한다. 상자 이동 전략 게임 Sokoban의 플레이를 위해 상상력 보강 에이전트 I2A가 개발된 바 있는데, 이 시스템은 결정을 내려야 할 때마다 테스트해볼 만한 경로(롤아웃)의 집합을 생성하고, 이전 게임 플레이 경험을 기반으로 각 롤아웃에 대한 보상 값을 계산하고, 모든 롤아웃을 합성항 가장 큰 보상과 연관된 행동을 결정함으로써, 수십 번의 사전 계획이 필요한 Sokoban 퍼즐을 안정적으로 해결할 수 있었다. | |||

이러한 성취는 연합주의적 마음이 인과저 관계와 의미론적 관계를 구별하지 못한다는 포더의 우려를 해결해준다. | |||

[[분류:과학철학]] | [[분류:과학철학]] | ||

2024년 6월 26일 (수) 20:19 기준 최신판

Cameron J. Buckner, From Deep Learning to Rational Machines: What the History of Philosophy Can Teach Us about the Future of Artificial Intelligence. Oxford University Press, Ch. 5.

경험한 적이 없는 새로운 표상을 산출하는 상상력은 경험주의적 접근에 큰 도전이었다. 흄은 연합 법칙 등을 이용해 상상력에 대해 꽤 많은 얘기를 했지만, 포더는 이에 만족하지 않았다. 버크너는 흄에 대한 포더의 반론들을 검토하면서, 딥러닝의 "생성" 모델들의 성공이 경험주의의 난점들을 해결해줄 수 있음을 보이고자 한다.

포더의 비판

연합주의에 대한 포더의 비판

첫째, 구체적 표상의 합성 문제 : 흄의 세 가지 연합 법칙(근접성, 유사성, 인과성)만으로는 구체적인 관념 토큰을 합성할 수 있는 능력을 설명하지 못한다. 엽합 법칙은 어떤 유형의 관념이 어떤 상황에서 호출되어야 하는지 말해주지만, 그 유형의 토큰이 어떻게 생성되는지 설명하지 않는다. 이를 위해 흄은 일반 범주의 적절하고 대표적인 표본(토큰)을 합성하는 능력이 필요하다고 말하지만, 그런 능력이 어떻게 작동하는지, 그러한 능력의 개인차가 왜 생겨나는지 설명하지 못하고 있다. 딥러닝은 바로 일반 범주의 적절한 토큰을 합성하는 능력에 대해 설명할 수 있을까?

둘째, 사고의 생산성 문제 : 경험주의적 마음은 과거에 한 번도 경험해 본 적 없는 새로운 복합 관념을 어떻게 형성할 수 있는가? 포더는 경험을 통해 획득한 관념의 분해와 자유로운 재합성에 호소하는 흄의 설명이 겉보기에만 훌륭할 뿐, 세부사항이 없는 빈 설명이라고 불평한다.

셋째, 사고 간의 인과적 관계와 의도적 관계 구별하기의 문제 : 포더에 따르면, 연합주의는 사고의 내용 사이의 의도적(의미론적) 관계와 사고 자체의 인과적 관계를 구별하지 못한다. ... 흄은 연합된 이미지는 경험에서 복사된 것이 아니라 상상력에 의해 종합된 것이며, 그 연합된 이미지의 강도를 통해 신뢰성을 검토한다고 얘기한 바 있는데, 이는 오늘날의 확률적 추론에 대한 휴리스틱 접근의 전신이라 할 수 있다.

흄의 상상력 설명에 대한 포더의 비판

첫째, 흄은 상상력의 작동을 설명하지 않는다. 흄은 상상력의 "모방적" 모드와 "생산적" 모드를 구분했고, "생산적" 모드에 대해 흄은 "관념 간의 쉬운 전환을 통해 결합을 형성하거나 전체를 완성하여 쾌락을 얻으려 한다", "노 젓는 배처럼 움직이기 시작하면, 그 객체들 사이의 일관성을 관찰하는 일련의 과정을 계속하며, 자연스럽게 일관성을 가능한 한 완벽하게 만들 때까지 계속된다", "다른 배경 세부 사항을 채워 넣어 명백한 모순을 완화하고 복합체를 더 그럴듯하게 만들기 위해" 노력한다는 점을 지적하며, 연합 원리의 제약 하에서 일관된 전체를 완성하려는 경향 및 그로 인한 쾌락을 지적한 바 있으며, 상상력에 대한 이러한 흄의 특성화는 오늘날 신경망 모델의 작동 원리인 "이전 경험을 바탕으로 주관적 확률을 최대화하는 방식으로 패턴을 재구성하려는 경향"과 직결된다. 따라서 포더의 비판은 다소 지나치다.

둘째, 상상력에 대한 흄의 설명이 모종의 순환이나 퇴행에 빠진다. 흄에 따르면 인간의 사고와 추론은 상상력에 의존하며, 이 상상력은 일반적 관념 대신 구체적 관념들 사이의 유사성을 고려한다. 그러나 상상력은 어떻게 무한한 유사성 중에서 어느 하나에 집중할 수 있는가? 예를 들어, 형태와 색상의 개념을 가지고 있지 않다면, 어떻게 우리는 흰 공과 검은 공이 형태는 유사하지만, 색상은 다르다고 인식할 수 있겠는가? 이러한 포더의 비판은 상상력에 대한 흄의 설명에 로크적 추상적 관념의 재도입할 필요성을 보여주며, 그것이 시스템 내에서 어떻게 구현될 수 있을지에 대한 현대적인 설명이 필요하다.

셋째, 새로운 복합 관념을 결합하는 접착제는 무엇인가? 이에 답하기 위해 버크너는 흄이 상상력에 귀속시킨 "완성주의" 원칙과 관련이 있다고 제안하려고 한다. 이 문제는 결국 딥페이크와 같은 그럴듯한 인공 표상을 생성하는 시스템을 만들어낼 때 직면하는 문제와 정확히 일치한다.

생물학적 타당성에 대한 주의사항 : 인공 모델이 생물학적 구조와 정확히 일치한다는 보장은 없으며, 기능주의를 채택하면 정확한 구조적 대응이 없다는 점이 별 문제가 안 될 수도 있다. 그럼에도 인공 모델과 생물학적 뇌는 다음과 같은 유사성이 있을 수 있다. (1) 계층적으로 구조화되고 추상화된 정보의 필요성 (2) 이전 경험에서 파생된 배경 확률 가정을 바탕으로 한 표상 구조의 새로운 결합의 가능성. 결국 인공 모델은 경험주의적 방식과 유사한 방식으로 추론과 표상의 문제를 해결할 수 있다는 "개념 증명"으로 작용할 것.

인공 신경망의 특정 표본 합성 능력

책 전반의 논제 : 마음이 명시적 추론에서 개별 범주 표본을 의식적으로 표상하고, 변형된 범주 매니폴드 형태로 로크적 일반 관념과 같은 것을 무의식적으로 표상한다.

우리 또는 인공 모델은 어떻게 새로운 (구체적인) 관념을 합성할 수 있는가? 이는 추상화와 반대 방향의 과정으로, "변형된 범주 매니폴드"에서 "완전한 렌더링된 특정 항목"으로 돌아가는 과정, 일반적인 범주 표상에서 특정한 관념으로 돌아가는 과정이다. 이를 위해 버크너는 적대적 생성 신경망에서부터 시작한다.

적대적 생성 신경망(GAN : 생성 신경망 + 판별 신경망) : 생성 신경망이 가짜 입력을 만들고, 판별 신경망은 그것이 진짜인지 가짜인지 판별함으로써, 생성 신경망 훈련시킨다. 그러면 GAN은 어떤 구조로 구체적인 가짜 입력을 만들어내고, 진짜 같은 가짜를 만들어내는 데 성공할 수 있을까?

생성 신경망은 기본적으로 DCNN과 유사하지만, 첫째, GAN의 입력은 (DCNN의 고차원 정보와 반대로) 저차원의 특징 공간(잠재 공간이라 부름)의 (랜덤) 벡터이며, GAN의 작동 과정은 (DCNN의 합성과 풀링의 반대로) 전치 합성곱과 언풀링으로 이루어지며, 이를 통해 생성 신경망은 저차원의 잠재 공간 벡터로부터 고해상도의 표본을 생성한다. 물론 처음에는 엉터리 표본을 생성하지만,판별 신경망의 판별 결과에 따른 훈련을 통해, 생성 신경망은 잠재 공간의 의미있는 특징들에 대한 풍부한 정보들을 활용할 수 있는 방식으로 진화하여, 판별 신경망을 속일 수 있는 표본을 생성하게 된다.

이를 위해 생성 신경망은 잠재 공간을 효율적으로 그룹화하는 방법을 학습해야 하며, 입력의 차원이 출력의 차원보다 작으므로, 생성 신경망은 판별 신경망의 영역에서 가장 넓은 범위의 분산을 설명하는 소수의 잠재 공간 차원으로 특징 공간을 압축하는 방법을 학습해야 하며, 잠재 공간 벡터에 명시되지 않은 일부 세부 사항을 그럴듯한 값으로 채워야 한다. 이 그럴듯한 추정치 역시 적대적 훈련 과정을 통해 점진적으로 조정된다.

전치 합성곱은 작은 행렬을 더 큰 행렬로 확장하는 데 사용되는 연산자. 이때 입력 행렬에 커널(번역기)이 반복 적용된다. 훈련은 효과적인 커널의 획득 과정으로 이해될 수 있다. 한편, (오토인코더에서 많이 사용되던) 언풀링은 풀링의 역과 유사한 작업을 수행한다. 그런데 언풀링은 신경망의 역방향 정보 전송을 필요로 하는데, 대부분의 GAN에서 이러한 역방향 정보 전송이 말이 안 되므로, GAN은 언풀링을 피하고 추가적인 전치 합성곱 층을 선호한다.

이러한 작업을 통해 높은 추상화 수준의 잠재 공간 벡터는 그럴듯한 고해상도 표본으로 렌더링될 수 있다. 그리고 이 합성된 표본은 (흄과 버클리의 견해와 유사하게) 추상적 범주를 대신해 추론 과정에 사용될 수 있다. 그리고 이러한 가능성은 포더가 흄에게 제기한 첫 번째 문제가 해결될 수 있음을 보여준다.

인공 신경망의 새로운 복합 관념의 합성 능력

GAN은 포더가 제기한 두 번째 문제, 즉 어떻게 경험주의적 마음이 새로운 관념을 합성할 수 있는지의 문제도 해결할 수 있다. GAN의 생성 신경망에 무작위 잡음 대신 잠재 공간의 특성과 잘 매핑된 벡터를 입력하면 원하는 여러 특징들을 가진 새로운 합성물을 생성할 수 있다. 이를 "내삽"의 방법이라 부른다. 예를 들어 잠재 공간 내에서 "남자", "안경 쓴 남자", "여자"의 벡터 좌표를 이용하면, "안경 쓴 남자"-"남자"+"여자"의 벡터를 생성 신경망에 입력하여 렌더링하면 "안경 쓴 여자"의 그럴듯한 표본을 생성할 수 있다. 이러한 방법은 스타일 벡터를 이용한 새로운 주제의 그림 생성에도 사용되었고, 대성공을 거두었다.

한 가지 추가적인 쟁점 : 잠재 요인을 모델에서 얼마나 명시적으로 표상해야 하는가? 대안적 접근 방법 중 하나인 변분 오토인코더(VAEs)는 잠재 요인을 명시적으로 분리해냄으로써 그러한 요인들을 혼합하고 조작하기 쉽게 만들어준다. VAE에 추가된 트릭들은 그 추출된 잠재 요인을 인간이 사용하는 것과 더 유사하게 만들어준다.

위와 같은 발전은 새로운 복합 관념을 생성하는 능력에 대한 포더의 문제제기에 대한 훌륭한 답이 될 수 있다. 위의 생성 신경망들은 경험으로부터 학습하지만, 그것의 재합성을 넘어 완전히 새로운 것을 조합할 수 있다. 이는 잠재 공간을 이용한 추상화된 특성들의 학습과 그 특성들의 조합, 특성의 전형적 표본 생성 능력에 기반하고, 이는 모두 경험주의 도구 상자의 범위 내에 잘 들어맞는다.

이에 대해 두 가지 반론이 가능하다. 첫째, 인공 신경망이 사용하는 내삽 절차가 과연 순수히 경험주의적인가? 둘째, 인공 신경망이 인간의 능력에는 도달하지 못하고 있지 않은가? 즉 내삽만 할 뿐, 외삽은 못하지 않는가? 이에 대해 버크너의 답은 다음과 같다. 첫째, 현재의 내삽 방법이 고전적인 방법을 사용하는 것은 프로그래머의 편의일 뿐, 영역 일반적인 내삽 방법은 탐구하면 된다. 둘째, 인강 신경망의 성취 충분히 인상적이며, 내삽과 외삽의 구분선은 애매하다. 어쩌면 인간이 외삽을 할 수 있다는 건 인간중심적 착각일 수도.

창의적 적대 신경망

이제 초점을 예술적 창의성에 제한해보자. 여기서 요구되는 새로움은 자유와 제약의 혼합이다. 즉 단순히 무작위적인 것은 미적으로 흥미롭지 않다. 흥미로운 형태의 새로움은 "이전 경험에 의해 정보를 제공받지만, 그에 비추어 볼 때 이해 가능하거나 가치 있고 생각될 수 있는 것의 한계를 밀어붙이는 것"이다. 예술적 목적을 위해 신경망의 두 가지 방향의 혁신을 생각해볼 수 있다. 첫째는 미적 판별 신경망, 둘째는 미적 생성 신경망. 미적 판별 신경망은 미적 우수성을 인간처럼 평가하도록 훈련시킨 신경망이고(e.g., DCM), 미적 생성 신경망은 형태나 스타일 면에서 새로움을 극대화하여 흥미로운 새로움 탐색에 특화된 신경망이다(e.g., CAN : 훈련 세트의 라벨에서 스타일 표현들을 학습한 후, 적대적 훈련 과정에서 새로운 스타일 표현을 학습하여 명시적으로 그것들과 벗어나는 표본을 생성).

경험의 시뮬레이션

시뮬레이션된 경험은 새로운 표상을 발견하고, 미래와 반사실적 상황을 생각하여 의사결정과 인과 추론에 도움을 줄 수 있다. 이 영역에서 상상은 에피소드 기억과 접합됨. 단, 알파고 등이 사용한 몬테카를로 트리 탐색은 경험적인 방법은 아니며, 지나치게 포괄적이며 이미 잘 정의된 탐색 공간을 활용한다. 여기서 추구하는 상상 기반 계획은 경험에 의해 안내되고, 더 효율적이고 현실 세계에서 문제 해결을 특징짓는 더 혼란스럽고 덜 정의된 탐색 공간에 적용될 수 있어야 한다.

수면이나 몽상의 역할이 약간 밝혀져 있다. 미로 탐색 훈련을 받는 쥐들에 대한 연구에서, 수면과 휴식 기간 동안 쥐들의 내측 측두엽은 이전 경로 및 새로운 경로에 대응되는 발화 패턴을 보였다. 인간과 동물의 효율적으로 보이는 학습 능력은, 휴식기에 일종의 시뮬레이션된 경험 덕분일 수 있다.

GAN 등 DNN 기반 생성 모델들도 유사한 이점을 얻을 수 있다. 예를 들어 SimGAN은 GAN 방법을 통해 수많은 시뮬레이션 데이터를 생성하고, 이를 통해 판별 신경망의 정확도를 향상시킨다. 물론 과적합의 우려가 있긴 하지만, 이를 피하는 방법도 이미 개발되어 있다.

의사결정에 시물레이션된 경험을 활용하는 데 있어 상상력이 수행하는 역할은 보다 까다롭다. 상상력은 완전한 탐색보다 효율적으로 고려한 미래 작업의 작은 집합을 채워주어야 한다. 상자 이동 전략 게임 Sokoban의 플레이를 위해 상상력 보강 에이전트 I2A가 개발된 바 있는데, 이 시스템은 결정을 내려야 할 때마다 테스트해볼 만한 경로(롤아웃)의 집합을 생성하고, 이전 게임 플레이 경험을 기반으로 각 롤아웃에 대한 보상 값을 계산하고, 모든 롤아웃을 합성항 가장 큰 보상과 연관된 행동을 결정함으로써, 수십 번의 사전 계획이 필요한 Sokoban 퍼즐을 안정적으로 해결할 수 있었다.

이러한 성취는 연합주의적 마음이 인과저 관계와 의미론적 관계를 구별하지 못한다는 포더의 우려를 해결해준다.